中国/广州 欧盟人工智能法案将于2024年强制执行, 为协助中国人工智能相关企业提前应对即将到来的国际监管,TÜV南德意志集团(以下简称“TÜV南德”)已推出人工智能评估服务:AI 质量架构评估方案。

本文为Trust AI@TÜV SÜD的系列专栏的第十篇:NIST 人工智能风险管理框架

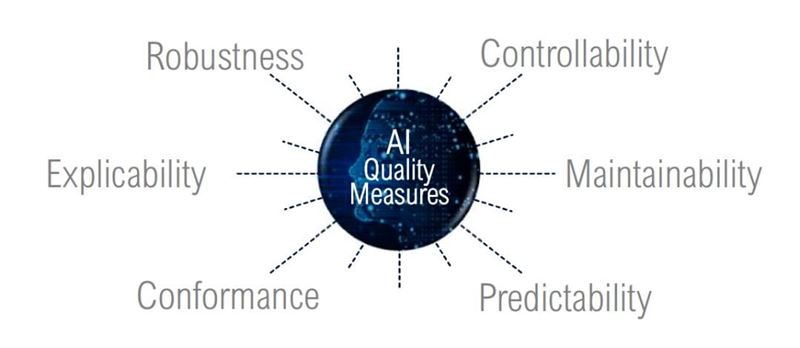

(AI 质量架构评估方案)

本期我们来关注北美的人工智能监管活动,讨论NIST发布的人工智能风险管理框架(Artificial Intelligence Risk Management Framework,简称AI RMF)。

美国国家标准技术研究所(NIST,National Institute of Standards and Technology)成立于1901年,隶属于美国商务部,是全球顶级的物理科学,测量学研究机构和标准化组织,致力于促进创新和产业竞争力,增强经济安全和改善人类生活质量。

2023年1月,NIST发布了第一版人工智能风险管理框架AI RMF,其目标是帮助设计、开发、部署或使用人工智能系统的组织提高人工智能风险管理的能力,并促进人工智能系统的可信度和负责任的开发和使用。虽然AI RMF只是一个自愿性的技术框架,但这一框架在正式发布前NIST已经通过几版公开的草稿版本,与人工智能学界和产业界进行了广泛的信息收集和讨论,并受到广泛关注,因此,此次AI RMF一经发布即成为业界公认的人工智能风险管理指导体系。

AI RMF将与人工智能系统相关的潜在危害大致分为三类,即对人类的危害、对组织的危害和对生态系统的危害。

当前对这些危害的有效测量与管理还存在着很多挑战。譬如,在AI系统中使用第三方软硬件和数据难以管理;目前缺乏对风险和可信度的稳定且可验证的度量方法的共识;对不同人工智能用例的适用性;在人工智能生命周期的不同阶段测量风险可能会产生与不同的结果;在实验室或受控环境中测量的人工智能的风险,可能会不同于在真实操作环境中出现的风险;不确定性的/有限解释性的人工智能系统会使风险测量复杂化;用于增强或代替人类决策的AI,很难以人类的行为作为基准进行比较和评估等等。

AI RMF框架并不是一种万能的解决方案,它需要根据组织的特定需求进行定制和实施。此外,该框架只是一个指导性工具,组织需要根据其实际情况进行判断和决策,制定相应的措施,在实践中建立组织的人工智能管理体系,并动态的持续改进。

增强AI的可信度可以在一定程度上降低AI的负面风险,AI RMF提出了7个可信赖AI的特征,分别是:有效&可靠,安全,弹性,可解释,隐私保护,公平,可问责&透明。NIST希望可以通过AI RMF带来如下改善:

AI RMF的核心工作是将AI风险管理分为了四大板块:治理,映射,测量,管理。每一个模块都再细分为更小的子分类,并且包括了具体的行动和结果。

为了方便人工智能相关组织和个人参考,NIST为AI RMF编制了简明的指导书,将各模块的具体信息以表格的型式陈列。AI RMF框架和指导书都已免费公开,有兴趣的相关人员可以直接下载参考。本文就不再赘述。

以下为AI RMF中总结的人工智能相较于传统软件所增加的风险:

对于人工智能开发企业和应用企业,人工智能的风险以及质量都是至关重要的。除了性能以外,人工智能在自主性,公平性,透明性与可解释性,数据保护,信息安全,可靠性与鲁棒性等格方面的风险都要得到有效的评估和控制。人工智能的风险管理应贯穿于从概念,开发,部署,运营直到退役的全生命周期。

TÜV南德作为全球领先的TIC (Testing, Inspection, Certification) 机构,在人工智能的审计领域也有着坚实的基础。TÜV南德全球数字服务中心首席技术官Martin Saebeck博士是ISO与IEC的联合技术委员会JTC 1/SC 42标准工作组的核心成员,并正在主持多项人工智能国际标准的起草工作。此外TÜV南德全领域的专家深入参与了各垂直领域,如医疗设备、自动驾驶、机械安全等的国际法规与标准起草工作。

在大中华区,TÜV南德也组建了专业的人工智能评估团队,该团队由TÜV南德大中华区商用产品和交通服务部高级副总裁Robert Puto先生领导,旨在帮助中国企业高质量的应用人工智能技术,开发并提供可信赖的人工智能相关产品与服务,经由TÜV南德的合规性检查及技术评估达到国际市场准入标准,并提供全生命周期的保障服务。

Site Selector

Global

Americas

Asia

Europe

Middle East and Africa